打造私人专属AI = 个人知识库 + 本地化部署deepseek模型 / deepseek官方模型(AnythingLLM版)

打造个人知识库(AnythingLLM版)- 私人专属AI-本地化部署deepseek模型 + deepseek官方模型。本篇介绍 AnythingLLM 的使用和配置。配置应用本地部署deepseek模型和官方deepseek模型两种方式。

上篇介绍了打造个人知识库(Page Assist版)- 私人专属AI-本地化部署deepseek。

打造私人专属AI = 个人知识库 + 本地化部署deepseek模型(Page Assist版)

本篇介绍 AnythingLLM 的使用和配置。配置应用本地部署deepseek模型和官方deepseek模型两种方式。

一、AnythingLLM介绍

AnythingLLM 是一款专为企业设计的智能管理工具,能够将复杂的AI技术转化为简单易用的解决方案。它支持接入多种主流AI模型(如ChatGPT),允许企业上传各类文档(合同、报告等),并像“随叫随到的专家”一样,快速解答员工或客户的提问。例如,销售数据查询、流程指引、客服答疑等场景均可自动化处理。其最大优势在于私有化部署,数据完全存储在企业自有服务器,保障信息安全;同时操作界面直观,无需技术背景即可上手,还能灵活更换AI模型适配不同需求。适合快速搭建企业知识库、优化客服效率或辅助内部培训,成本低、见效快,是提升团队智能化水平的轻量级工具。

二、AnythingLLM下载安装

下载地址:下载anythingllm

根据你系统选择下载对应的软件包安装,正常执行安装即可。

三、新建工作区

新建一个工作区

四、AnythingLLM + Ollama

LLM选 Ollama,应用本地的部署的模型。

1. LLM 首选项

点击设置 - LLM 首选项

2. 嵌入首选项

嵌入式模型用于知识库文档向量化写入向量数据库、向量数据库检索。

五、工作区设置

测试提问:

默认回复语言为英文。

聊天设置:

聊天设置:

“聊天提示”、“查询模式拒绝响应”设置为中文内容,模型输出转变为中文。

设置参考:

聊天提示:根据以下对话、相关背景和后续问题,回答用户当前提出的问题。根据需要,按照用户说明,仅返回您对上述信息问题的回答。

查询模式拒绝响应:没有相关内容回答您的问题

再次提问效果:

六、上传知识库文档

上传知识库文档。

确认保存。

等待模型把文档加载进向量数据库。

如需要上面的知识库文档,请查看 打造个人知识库(Page Assist版)- 私人专属AI-本地化部署deepseek

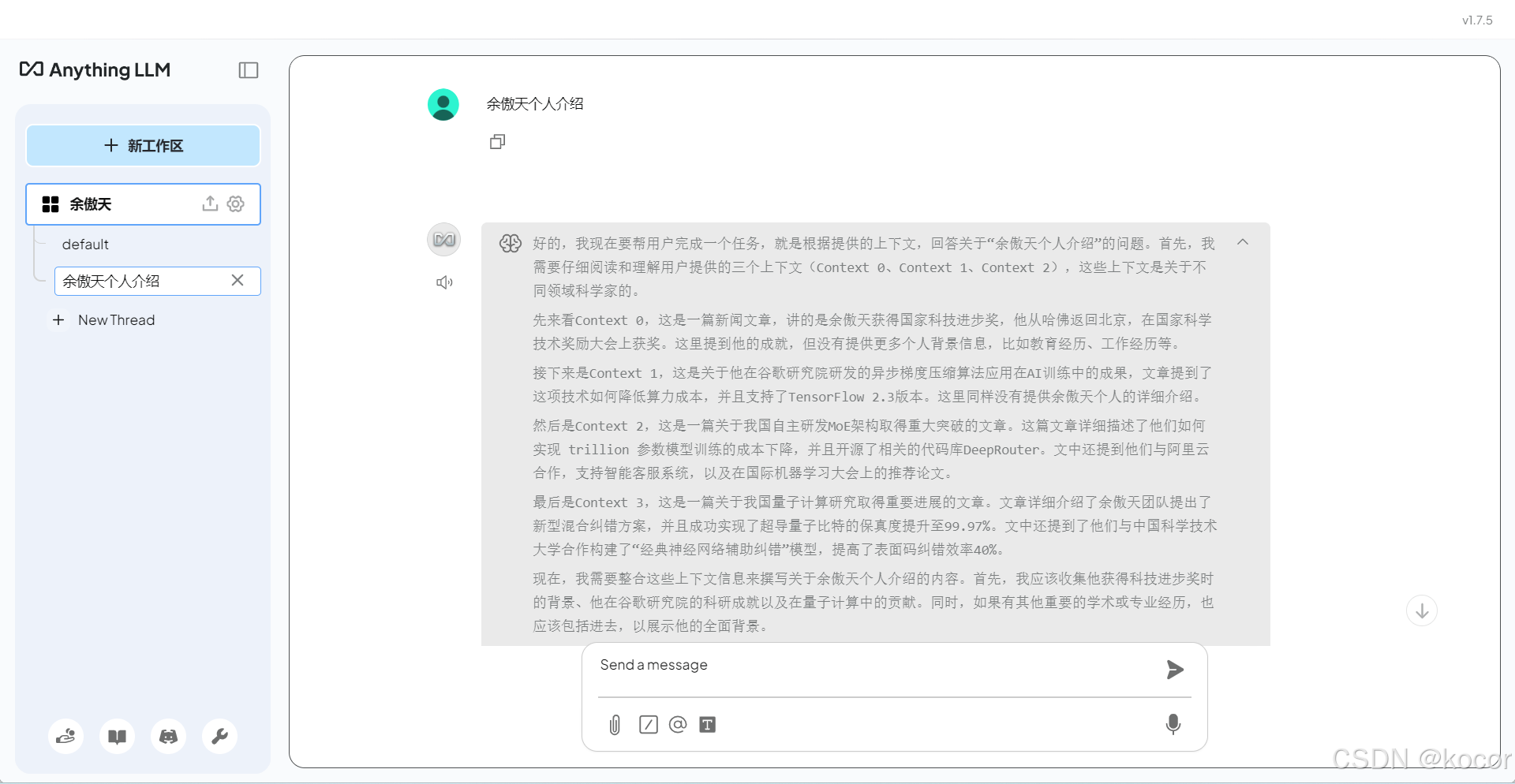

七、本地部署模型测试效果

模型引用了知识库内容并给出正确的回答。文末给出了引用的具体文件。

八、AnythingLLM + Deepseek官方模型

对接 Deepseek API,应用官方的模型进行应答。不再受限与个人电脑配置,本地部署的小模型,达到更好的回复效果。

1. 获取 Deepseek API KEY。

登录 Deepseek 开放平台。

登录地址:Deepseek 开放平台

“API keys” - 创建“API keys”

API key 仅在创建时可见可复制,请妥善保存。

2. 创建新的工作区。

3. 工作区“配置” - “聊天设置”。

4. “工作区 LLM 提供者”选择“Deepseek”。

工作区应用默认系统设置的LLM提供者。这里自定义成“Deepseek”。

填入前面准备好的 API KEY,根据需求选择 Deepseek 模型。

以下是 Deepseek-Chat 和 Deepseek-Reasoner 的对比:

| 对比维度 | Deepseek-Chat | Deepseek-Reasoner |

|---|---|---|

| 核心定位 | 自然对话交互 | 复杂问题推理与解决 |

| 主要能力 | 多轮对话、情感回应、上下文理解 | 逻辑分析、数学推导、代码生成、多步骤问题拆解 |

| 适用场景 | 客服、日常咨询、个人助手、社交陪伴 | 教育解题、科研分析、编程辅助、策略规划 |

| 输出特点 | 口语化、简洁流畅、注重交互连贯性 | 结构化、步骤化、强调准确性与逻辑严谨性 |

| 用户需求 | 快速沟通、拟人化交互 | 深度分析、专业解决方案 |

| 典型应用举例 | - 回答产品问题 - 闲聊陪伴 - 信息查询 |

- 数学题分步解答 - 生成代码 - 实验设计 |

5. 新工作区上传知识库文档。参看上面。

九、Deepseek官方模型测试效果

1. 余额不足

有相关提示,记得先去充值。

2. Deepseek-Chat 测试效果

直接回答问题,没有推理过程,回答的内容比较简单。消耗的 TOKEN 比较少。

3. Deepseek-Reasoner 测试效果

有推理过程,回答的内容比较丰富。消耗的 TOKEN 比较多。

十、其他设置调优

1. 聊天模式

工作区设置 - 聊天设置 - 聊天模式

分聊天和查询两个选项,根据需求选择

聊天:提供 LLM 的一般知识 和 找到的文档上下文的答案。

查询:提供找到的文档上下文的答案。

2. LLM 温度

工作区设置 - 聊天设置 - LLM 温度

根据需求适当调整该值大小,数字越高模型越自由发挥创意,可能会出现虚构的信息,影响问答的正确性。

3. 最大上下文片段

工作区设置 - 向量数据库 - 最大上下文片段

可适当调整该值,控制发送给模型的上下文片段大小,影响前后回答的连贯性。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)