【fastgpt系列】开篇之fastgpt本地部署+添加ollama和千问模型实战

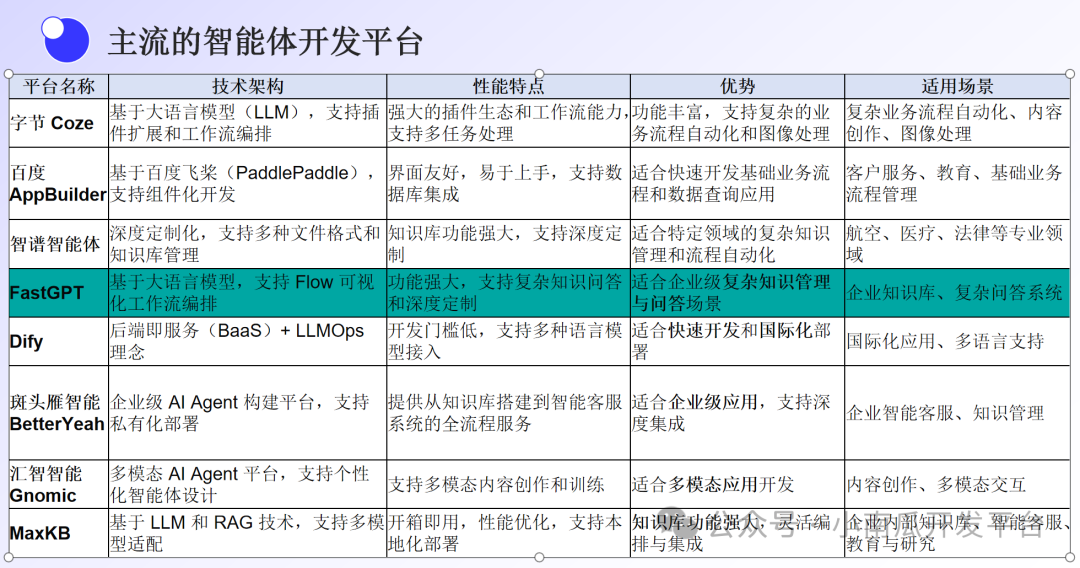

因项目需要,在技术选型时放弃了dify,选择了fastgpt,因此后续相关智能体的实战开发案例将会基于fastgpt开发平台进行分享.

一、前言

因项目需要,在技术选型时放弃了dify,选择了fastgpt,因此后续相关智能体的实战开发案例将会基于fastgpt开发平台进行分享.

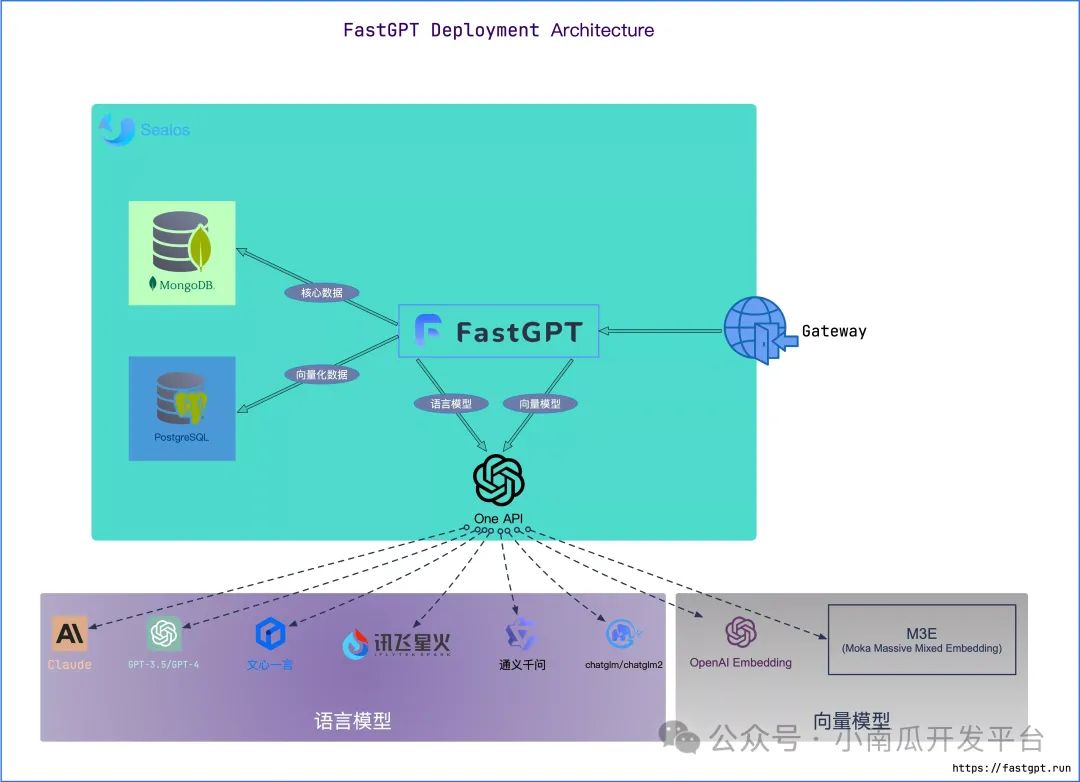

二、部署架构

三、安装步骤

1、准备 Docker 环境

2、开始部署

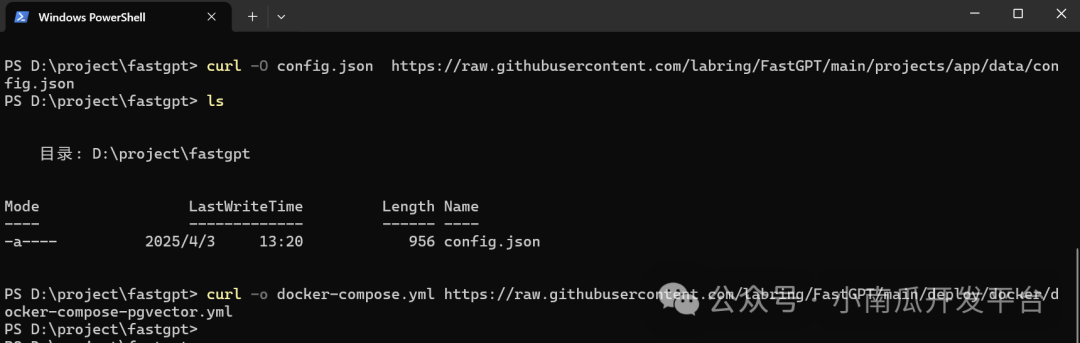

2.1 下载 docker-compose.yml

创建一个新的目录,进入到目录打开powershell执行如下命令:

curl -O config.json https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json

# pgvector 版本(测试推荐,简单快捷)

curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/deploy/docker/docker-compose-pgvector.yml

# milvus 版本

# curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/deploy/docker/docker-compose-milvus.yml

# zilliz 版本

# curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/deploy/docker/docker-compose-zilliz.yml

下载到如下文件:

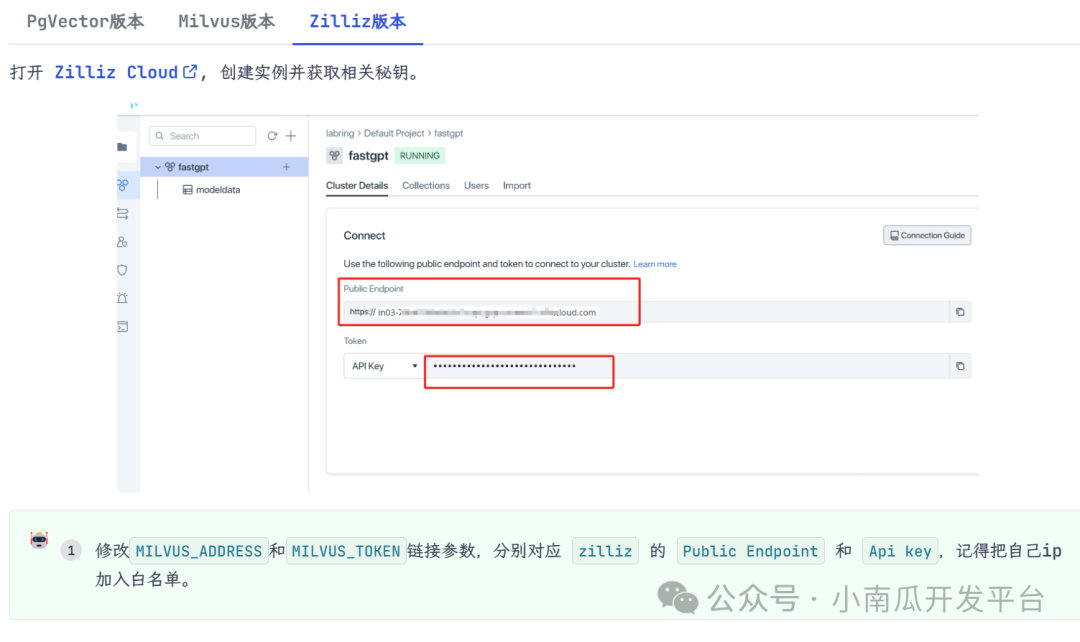

2.2、修改环境变量

找到 yml 文件中,fastgpt 容器的环境变量进行下面操作:

PgVector版本:无需操作

Milvus版本:无需操作

Zilliz版本:参考教程操作

由于本次是基于pgvector版本安装,所以可以忽略该步骤

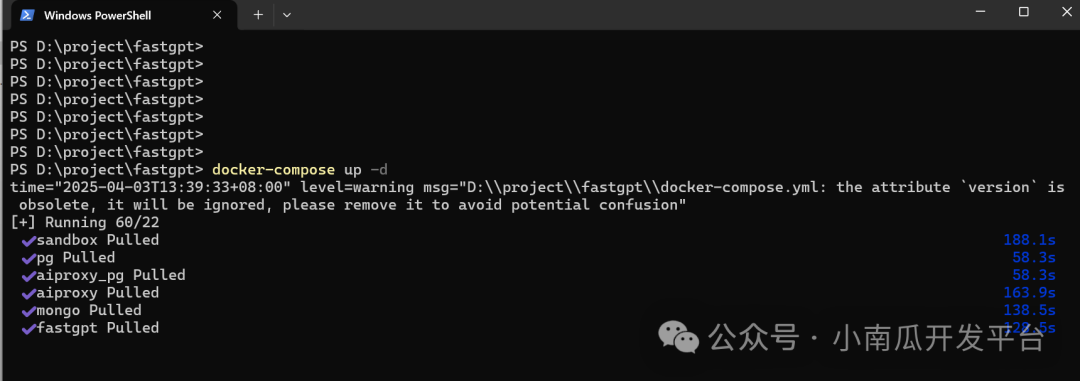

2.3、启动容器

在 docker-compose.yml 同级目录下执行。请确保docker-compose版本最好在2.17以上,否则可能无法执行自动化命令。

下载启动成功如图:

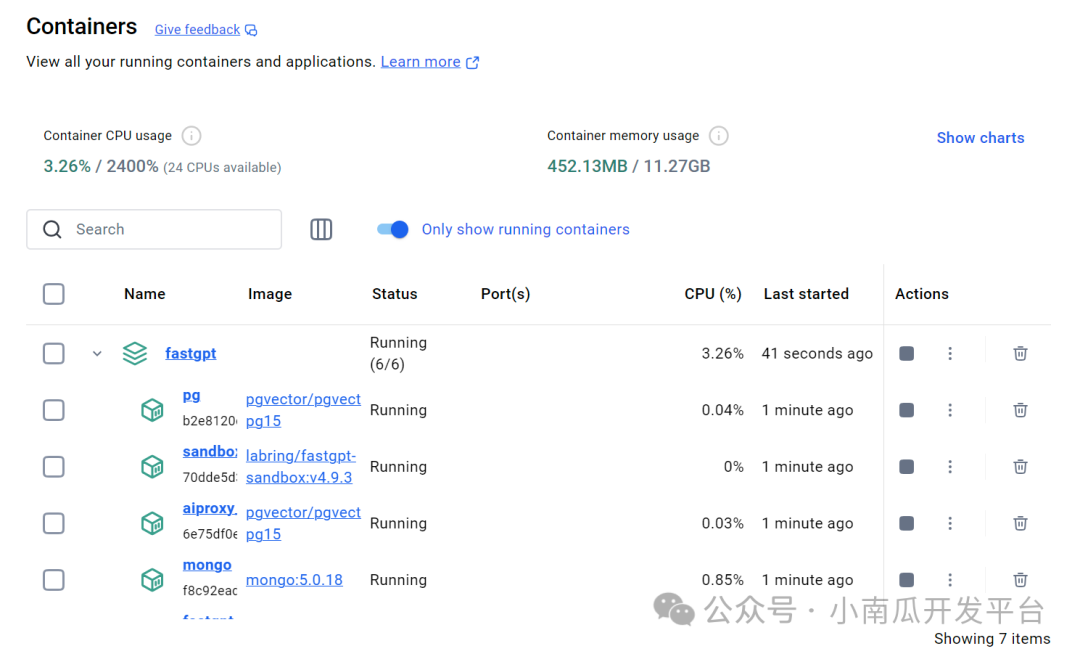

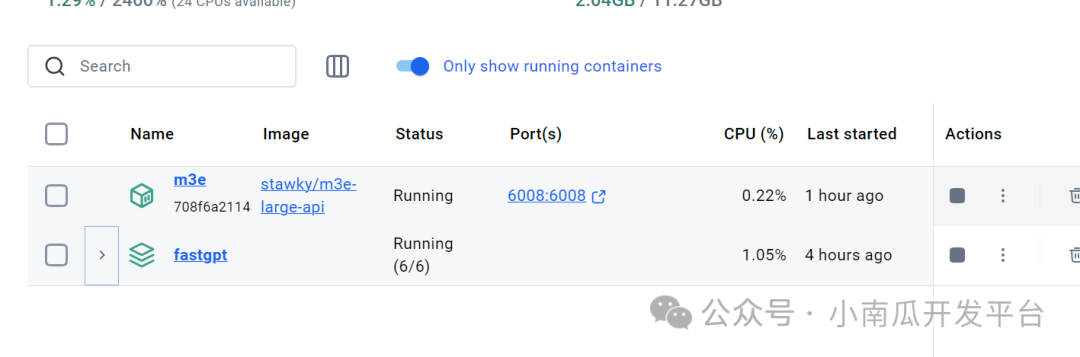

docker desktop界面:

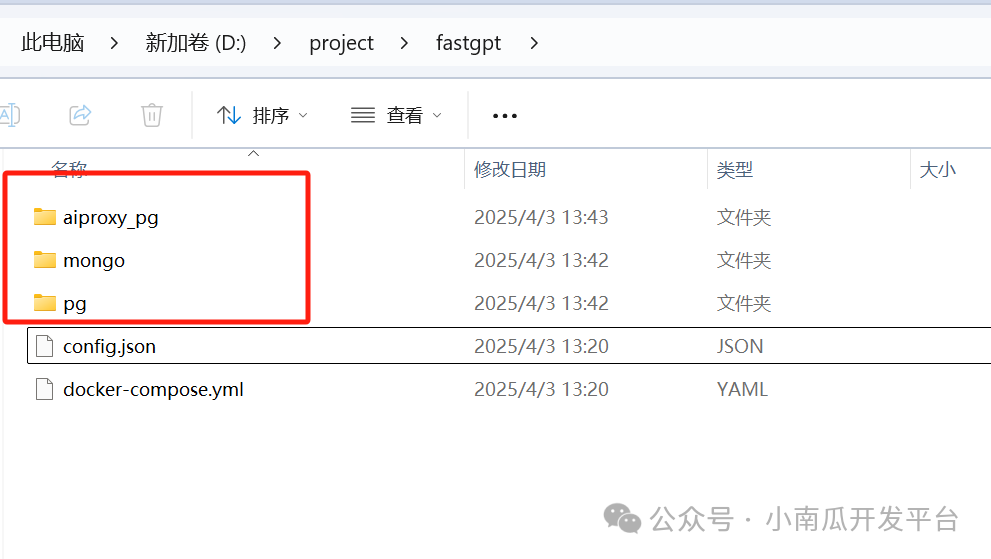

文件夹下多了3个目录:

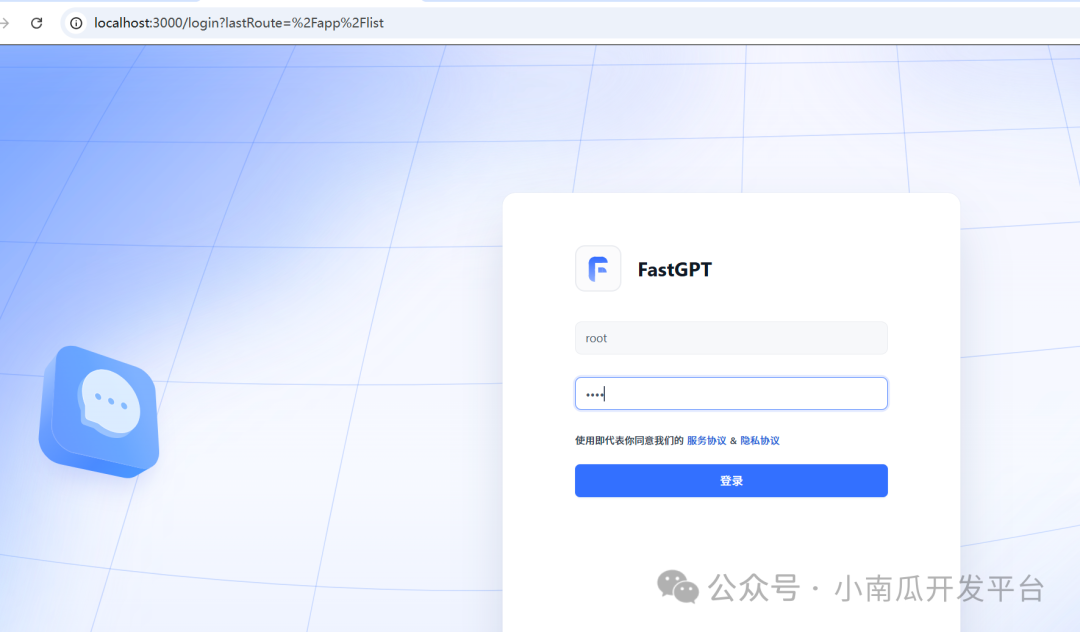

2.4、 访问

目前可以通过 ip:3000 直接访问(注意开放防火墙)。登录用户名为 root,密码为docker-compose.yml环境变量里设置的 DEFAULT_ROOT_PSW。

如果需要域名访问,请自行安装并配置 Nginx。

首次运行,会自动初始化 root 用户,密码为 1234(与环境变量中的DEFAULT_ROOT_PSW一致),日志可能会提示一次MongoServerError: Unable to read from a snapshot due to pending collection catalog changes;可忽略。

登录界面:

登录成功界面:

关于fastgpt

FastGPT 是由环界 云计算 公司发起的一款 开源知识库问答系统,基于大语言模型(LLM)构建,旨在为用户提供高效便捷的知识管理与问答能力。其最大的特点在于提供了开箱即用的数据处理与模型调用功能,用户无需复杂配置即可快速上手。

此外,FastGPT 还支持 Flow 可视化工作流编排,帮助用户灵活设计和实现复杂的问答场景。这一特性不仅极大地提升了工具的可操作性,还为多样化的业务需求提供了强有力的支持,使其成为企业和开发者在知识问答领域的理想选择。

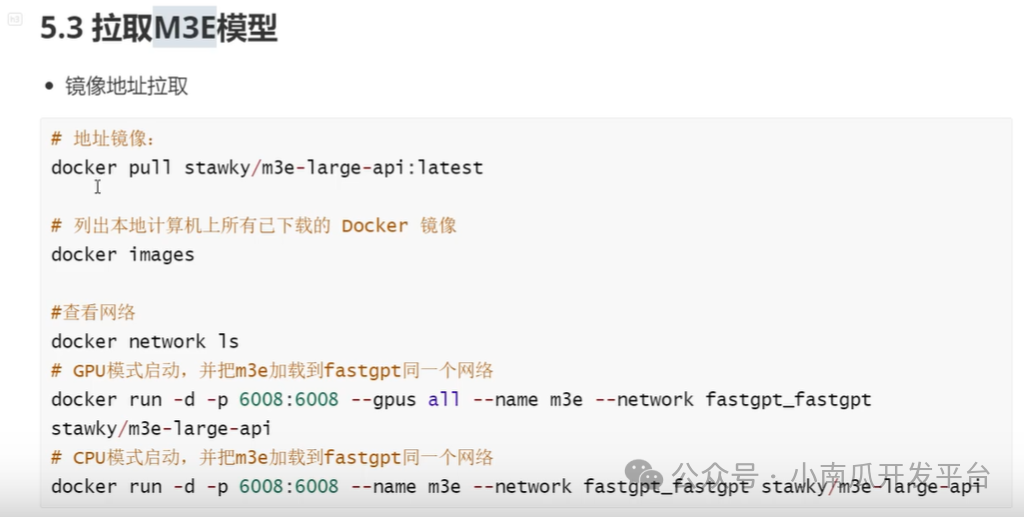

四、M3E模型部署

1、拉取镜像

docker pull stawky/m3e-large-api:latest

2、启动镜像

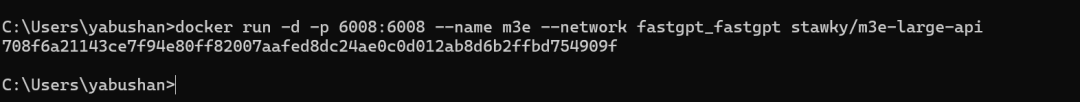

cpu模式启动

docker run -d -p 6008:6008 --name m3e --network fastgpt_fastgpt stawky/m3e-large-api

启动成功如下图:

其他命令:

五、添加模型

初始化 root 用户,密码为 1234

(与环境变量中的DEFAULT_ROOT_PSW一致)

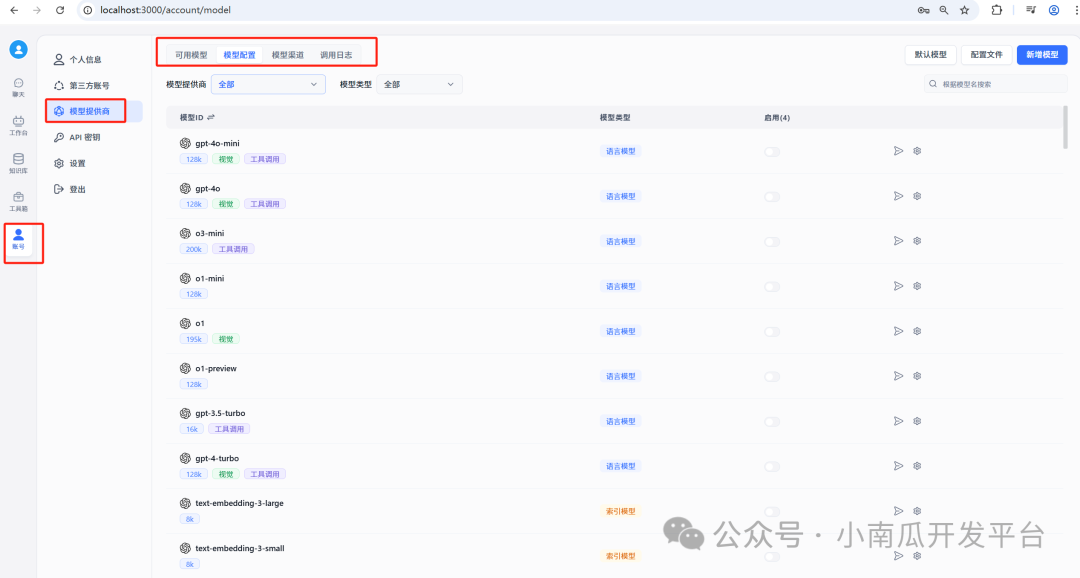

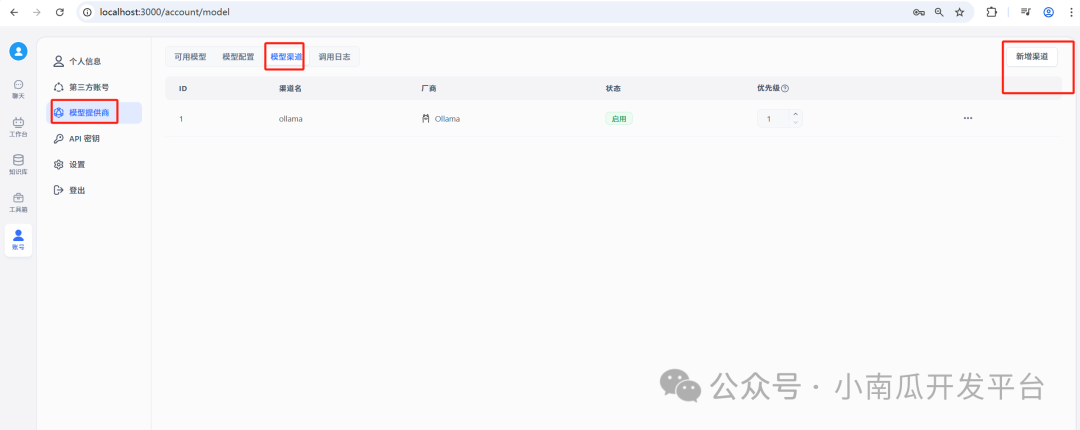

进入系统》账号》模型提供商页面

添加阿里百炼平台的第三方模型

1.1、登录阿里官网,选择需要的模型

https://bailian.console.aliyun.com/#/model-market

1.2、点击API调用示例,获取到http请求的url以及apikey

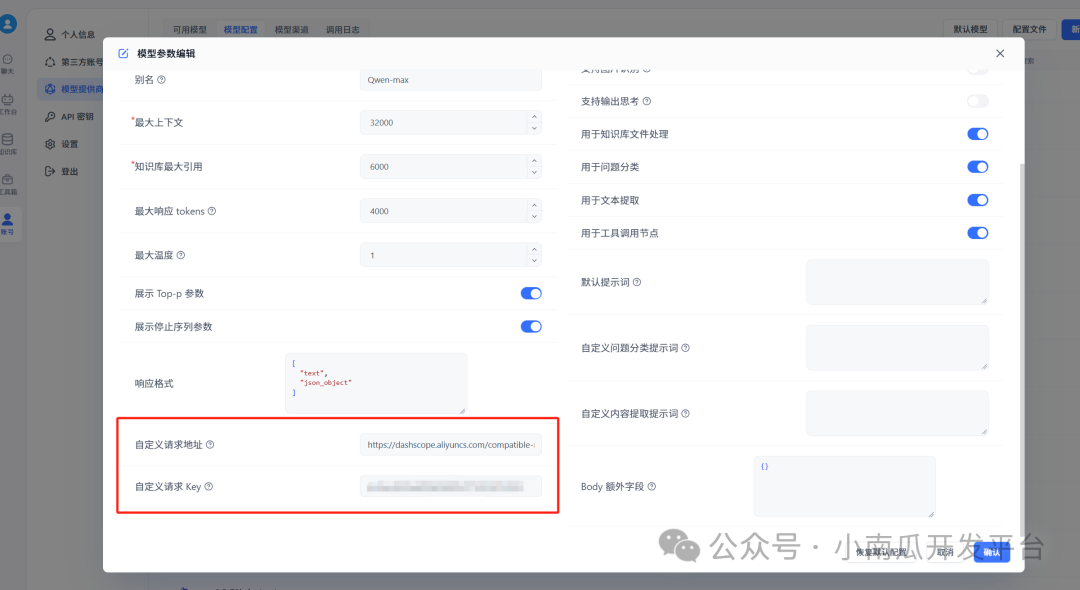

1.3、在模型配置中找到对应的模型,点击启用和设置

点击设置后,进入配置页面;配置url和key为从阿里平台获取到到url和key

点击纸飞机按钮进行测试

等待片刻后,输入成功按钮,则模型添加成功

添加本地ollama模型

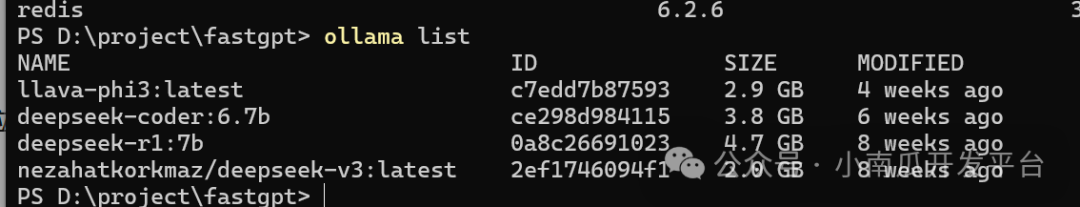

1、本地通过ollama下载和安装对应的模型后,输入ollama list查看本地已安装的模型

2、登录到fastgpt页面新增模型渠道

点击新增渠道后,新增模型、配置url地址信息

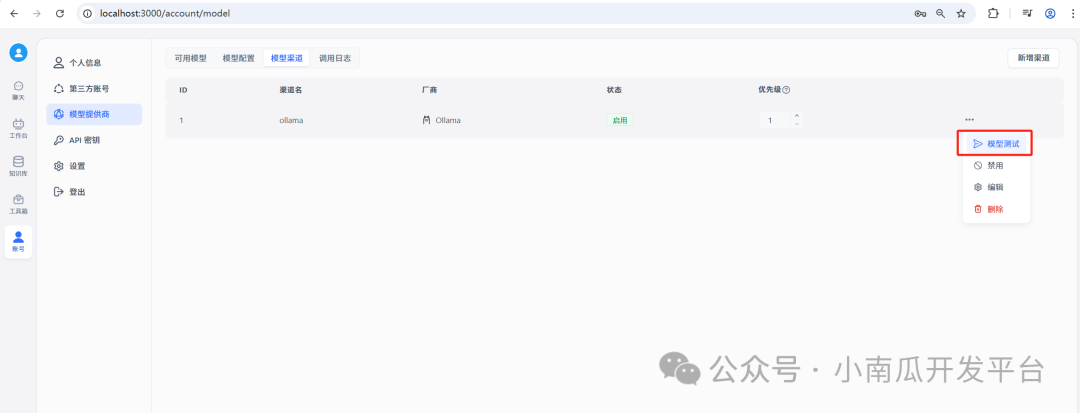

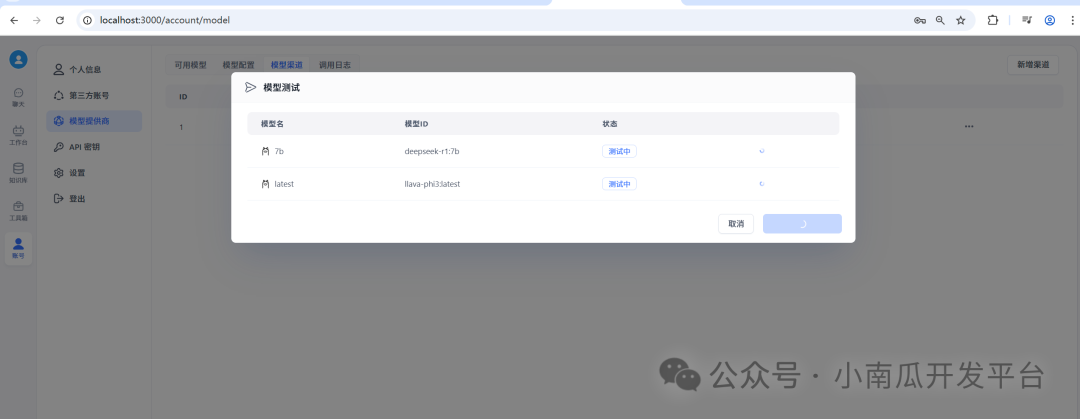

点击模型测试

等待测试结果:

请求成功

经过如上步骤后,在可用模型中就可以看到我们配置的这4个模型了

接下来可以开始探索FastGPT了(●’◡’●)

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

更多推荐

已为社区贡献65条内容

已为社区贡献65条内容

所有评论(0)