百度中文分词词库:构建与应用

本文还有配套的精品资源,点击获取简介:自然语言处理中,中文分词是文本分析等任务的基础。百度中文分词词库提供了大量经过挑选和标注的中文词汇,旨在提升分词算法的准确性和效率。该词库支持规则和统计两种分词方法,包含常规词汇和特殊规则,适用于新词识别和歧义消除。词库的不断更新适应了语言的动态变化。用户可通过特定网站下载词库文件,经处理后可应用于各类中文文本处理系统中。...

简介:自然语言处理中,中文分词是文本分析等任务的基础。百度中文分词词库提供了大量经过挑选和标注的中文词汇,旨在提升分词算法的准确性和效率。该词库支持规则和统计两种分词方法,包含常规词汇和特殊规则,适用于新词识别和歧义消除。词库的不断更新适应了语言的动态变化。用户可通过特定网站下载词库文件,经处理后可应用于各类中文文本处理系统中。

1. 中文分词在自然语言处理中的重要性

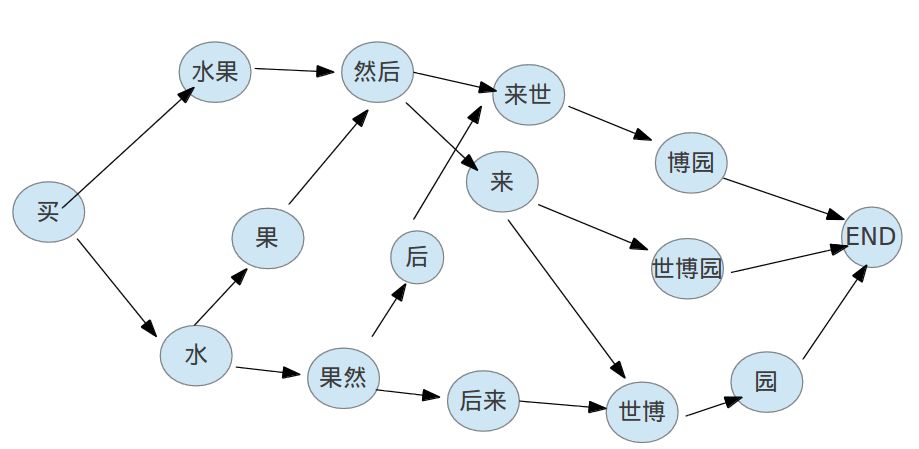

在自然语言处理(NLP)领域中,中文分词是基础也是关键环节。中文句子没有空格分隔单词,所以计算机需要通过算法来识别文本中的单词边界,这就是中文分词要解决的问题。中文分词的准确性直接影响到后续的语义理解、情感分析、机器翻译等复杂任务。本章将深入探讨中文分词的重要性,并分析其在NLP技术中的核心作用。此外,我们会简要介绍分词技术的发展历程,以及它如何成为现代中文信息处理不可或缺的一部分。

2. 百度中文分词词库的组成与特点

2.1 百度中文分词词库的基本构成

2.1.1 常用词汇与专业术语集合

在中文分词中,词库扮演着至关重要的角色。为了满足各种分词需求,百度中文分词词库涵盖了大量常用词汇和专业术语。词库中的常用词汇集合通常包括日常交流、新闻报道、网络文本等各领域高频出现的词汇,而专业术语集合则为处理学术文章、行业报告等提供了有力支持。

举个例子,对于金融行业的专业术语“量化宽松”、“证券市场”等,在词库中有明确的标注和分类,这使得分词系统在处理此类专业文本时能更加准确地识别词汇边界,从而提供正确的分词结果。

2.1.2 词库的结构化设计与数据格式

百度中文分词词库采用了结构化设计,以适应不同的检索和处理需求。数据格式方面,词库通常采用文本文件存储,每个词汇以一定的分隔符(如逗号、制表符)进行分隔,方便程序进行读取和解析。此外,词库中还包含了词汇的属性信息,如词性标注、拼音、同义词等,这样的设计大大增强了分词系统的灵活性和准确性。

例如,百度词库会针对每个词条提供如下的信息:

- 词条本身:中文词汇或短语

- 词性:名词、动词、形容词等

- 拼音:每个字对应的拼音

- 例句:词条在句子中的使用示例

这种结构化的设计使得分词系统在使用百度词库时能够更高效地处理词义消歧和上下文理解,提供更为准确的分词结果。

2.2 百度中文分词词库的应用优势

2.2.1 高准确率的分词技术

百度中文分词词库在实际应用中展现了高准确率的分词技术。这得益于百度在搜索引擎和自然语言处理领域多年的积累和优化。百度采用先进的算法结合自身庞大的词库,可以有效处理歧义、新词等问题,使得分词结果更为精确。

在分词准确性上,百度中文分词通过以下方式提升分词质量:

- 语料库的广泛覆盖 :使用海量的语料库进行训练,确保分词系统能够覆盖尽可能多的词汇和用法。

- 算法的深度优化 :借助深度学习等技术,对分词算法进行优化,以提升对复杂语境的理解能力。

- 实时更新机制 :随着新词、新义项的不断产生,词库也实现了持续更新,保证了分词的时效性。

2.2.2 词库对中文语言特点的适应性

百度中文分词词库不仅覆盖了中文语言中的常用词汇和专业术语,还考虑到了中文语言的特殊性。例如,中文中的多音字问题、成语和短语的识别、以及特定语境下的词义消歧等问题,百度词库都有很好的适应性。

例如,对于多音字的处理,百度词库会根据上下文来判断应该使用哪一个读音。如“银行”一词,在金融领域通常读作“yín háng”,而在“南银”这样的地名中则读作“nán yín”。词库中记录了这种用法,使得分词系统能够根据实际语境作出正确的判断。

此外,对于成语和固定短语的识别,百度词库也做了特殊的标记,以便系统可以识别并将其作为一个整体进行处理,而不是将成语中的每个字分别进行分词,从而提高了分词的准确性和自然度。

为了更好地适应中文语言的特点,百度词库还不断进行优化和更新,比如引入更多的成语、俚语、网络新词等,使词库能够更加贴合用户的实际使用需求。

3. 规则和统计分词方法的词库支持

3.1 规则分词技术的词库实现

3.1.1 规则分词的基本原理

规则分词是基于一系列预定义的分词规则来识别文本中的词汇。这些规则通常涉及到语言学知识,如语素、词性、句法结构等。在中文分词中,规则分词依赖于对汉字组合模式的理解,依据词典和各种语言知识来切分文本。具体实现时,分词系统会根据规则库中的规则,对句子进行从左到右的扫描,每匹配到一条规则就进行一次分词操作。

一个典型的规则分词系统包括词典和规则两大部分。词典里存储了所有已知的词汇和它们的属性信息。规则部分则提供了一些启发式的方法来处理词典中不存在的词汇组合。当遇到生词时,规则分词可能会借助上下文信息来推断切分的位置。

例如,常见的分词规则包括“最大匹配”和“最小匹配”策略。最大匹配策略尽可能多地匹配词典中的长词,而最小匹配则相反,优先匹配短词。具体采用哪种策略,取决于分词系统的设计和应用场景。

# 示例:实现一个简单的最大匹配分词器

def max_match_segmentation(text, word_dict, max_len):

index = 0

while index < len(text):

max_word_len = 1

match_word = ''

for length in range(max_len, 0, -1):

word = text[index:index+length]

if word in word_dict:

match_word = word

max_word_len = length

break

if max_word_len == 1:

# Handle unregistered characters or OOV (Out Of Vocabulary)

pass

yield match_word

index += max_word_len

# 假设的词典

word_dict = {'我们', '会', '继续', '优化', '中文', '分词', '技术', '和', '规则'}

# 示例文本

text = '我们会继续优化中文分词技术'

# 最大匹配长度

max_len = 3

# 分词操作

segmented = list(max_match_segmentation(text, word_dict, max_len))

print(segmented)

3.1.2 规则库的构建与应用实例

构建一个有效的规则库通常需要大量的人工介入。语言学家和数据工程师必须共同工作,收集语言材料,研究语言规则,并将其转化为机器可读的格式。高质量的规则库是规则分词系统性能的关键。

在实际应用中,规则库通常包括但不限于以下内容:

- 词典库 :包含所有已知词汇及其属性,如词性、词频、构词信息等。

- 句法结构规则 :描述词语组合的句法规则。

- 特定领域词汇 :针对特定领域或话题的专有词汇。

- 歧义消解规则 :用于解决分词中出现的歧义问题。

以医疗领域的中文分词为例,由于该领域的专业术语非常丰富,规则库中必须包含大量的医疗专业词汇和术语的组合规则。例如,“脑卒中”、“白血病”、“病毒性肝炎”等。

graph TD

A[开始分词] --> B{是否已处理完所有文本?}

B -- 否 --> C[加载下一段文本]

C --> D[查找匹配规则]

D --> E{是否匹配到规则?}

E -- 是 --> F[输出分词结果]

E -- 否 --> G[尝试更短的匹配]

G --> E

F --> B

B -- 是 --> H[结束分词]

3.2 统计分词技术的词库支持

3.2.1 统计分词的核心算法

统计分词方法主要依据大量真实语料库中的词频信息和词语出现的统计概率来进行分词。与规则分词不同,统计分词不依赖于预定义的规则,而是通过机器学习算法从数据中自动学习分词模式。其核心思想是:在一个足够大的语料库上,统计每个词语出现的概率及其与其他词语一起出现的概率,构建一个统计模型,然后用这个模型去预测新句子中的词边界。

统计分词模型通常包括隐马尔可夫模型(HMM)、条件随机场(CRF)和神经网络模型等。这些模型可以通过训练获得最佳的分词效果,但对于模型的训练和参数调优通常需要大量的计算资源和时间。

3.2.2 统计模型与词库的协同工作

统计分词系统的工作流程一般包括两个主要部分:模型训练和实际分词。在模型训练阶段,需要准备大量的分好词的文本数据,通过统计模型学习词语间的相互关系和出现概率。模型训练好之后,就可以用它来对新的文本数据进行分词处理。

词库在统计分词模型中发挥着数据来源的作用。词库提供了分词模型学习的原始数据,帮助模型了解哪些词是常见的,哪些词是很少出现的。此外,词库还可以提供一些词性和句法上的信息,辅助模型更好地理解语言结构。

# 示例:使用CRF模型进行分词

# 假设已有经过训练的CRF模型和一组输入文本

import pycrf

# 加载预训练的CRF模型

crf_model = pycrf.CRFModel()

# 加载输入文本

input_text = "我们会在实践中不断优化中文分词技术和词库"

# 使用模型进行分词

segmented_result = crf_model.tag(input_text)

print(segmented_result)

表格:规则分词与统计分词对比

| 特性 | 规则分词 | 统计分词 | |-------------------|---------------------------|---------------------------| | 主要依赖方式 | 预定义的规则集 | 统计模型及其学习到的模式 | | 适应性 | 可能需要频繁更新规则以适应新词 | 自动学习,适应性较好 | | 处理歧义 | 依赖特定规则处理歧义问题 | 依赖统计信息处理歧义问题 | | 需求资源 | 较少的数据和计算资源 | 大量数据和计算资源 | | 分词速度 | 较快 | 较慢 | | 准确率 | 取决于规则库的质量 | 取决于模型训练的质量和数据量 |

请注意,实际中规则分词和统计分词往往不是孤立使用的。很多先进的分词系统都结合了规则分词和统计分词的优势,以提高分词的准确性和效率。

4. 新词识别与歧义消除的特殊处理规则

4.1 新词识别的策略与实践

随着互联网和社会的发展,新词不断涌现,对于分词系统来说,及时识别新词并将其加入词库变得尤为重要。本节将深入探讨新词识别的策略与实践过程。

4.1.1 新词出现的语境分析

新词通常由社会热点、科技发展、文化交流等多方面因素催生,它们在特定的语境下频繁出现。因此,语境分析是新词识别的首要步骤。通过监测社交媒体、新闻报道、专业论坛等领域的用词,可以捕捉到新词的使用趋势和语境特征。

4.1.2 新词识别算法的实现

新词识别算法需要具备从语料库中检测未登录词(未出现在词库中的词)的能力。常见的实现方法包括基于统计模型、基于规则的方法和机器学习方法。以统计模型为例,可以构建一个以词频和词长为基础的候选词生成模型,然后通过判断其与已知词汇的重叠程度来识别新词。

# 示例代码:基于Python实现的简单新词识别函数

def recognize_new_words(corpus):

# 假设corpus为语料库中的一个句子

words = corpus.split()

new_words = []

for w in words:

if w not in word_list: # word_list为已知词汇库

# 计算新词的重叠度

overlap = calculate_overlap(w)

# 如果重叠度低于阈值,则认为是新词

if overlap < THRESHOLD:

new_words.append(w)

return new_words

def calculate_overlap(word):

# 这里需要一个具体的算法来计算重叠度

pass

在这个例子中, recognize_new_words 函数负责识别语料中的新词, calculate_overlap 函数用于计算新词与已知词汇的重叠程度,参数 THRESHOLD 为预设的阈值。代码逻辑说明新词识别依赖于语境分析和算法实现的结合。

4.2 歧义消除的技术手段

4.2.1 歧义现象及其成因

在中文分词过程中,歧义现象是一个常见问题,它主要源于词语的多样性和语言的复杂性。歧义分为两种:交集型歧义和组合型歧义。交集型歧义指的是一个字串可以分别与两个或两个以上的词相连,如“保护”和“护目”;组合型歧义则是指不同的词组合在一块,形成歧义,如“银行家”可以是“银行/家”或“银/行家”。

4.2.2 多种歧义消除策略的综合运用

为了解决歧义问题,研究人员和工程师开发了多种策略。首先,可以通过引入语境信息来判断最有可能的分词结果,比如利用N-gram语言模型。其次,可以采用基于规则的方法,设定一些消除歧义的规则,如长度优先原则,优先考虑最长的词。此外,还可以采用机器学习方法,训练模型来识别最佳分词方案。

graph TD

A[开始分词] --> B[初步分词结果]

B --> C{检查歧义}

C -->|存在歧义| D[应用语境信息]

C -->|无歧义| E[输出最终分词结果]

D --> F[应用规则消除歧义]

F --> E

E --> G[训练歧义消除模型]

G --> E

在上述的流程图中,可以看出歧义消除的过程是一个综合决策系统,运用了语境分析、规则判断以及模型训练等多种技术手段。通过逐步筛选和决策,最终确定了消除歧义的分词方案。

综上所述,新词识别和歧义消除是中文分词中不可或缺的环节。通过深入分析语境,合理应用算法,不断优化处理策略,才能不断提升中文分词系统的准确性和效率。同时,随着技术的不断进步,新词的快速识别和歧义的有效消除依然是自然语言处理领域研究的热点和难点。

5. 分词词库的持续更新与维护

维护一个分词词库是一个持续的过程,涉及到不断的更新和优化,以保持其准确性和高效性。一个良好的维护策略不仅能够提高词库的覆盖度,还能保证它与时俱进,适应新的语言现象和用户需求。

5.1 分词词库更新机制

5.1.1 更新策略与周期

更新分词词库通常需要遵循特定的策略和周期。策略会基于不同的标准,如数据来源的可靠性和更新频率,用户的反馈,以及新的语言资料的出现。一般情况下,更新周期可以是日更、周更、月更,甚至是季更,具体取决于资源可用性和词库的使用强度。

一个有效的更新周期应该是动态的,可以根据以下指标进行调整: - 新词的出现频率 :如果新词增长速率较高,可能需要缩短更新周期。 - 用户反馈的数量和质量 :用户反馈可以提供词库的实时使用情况,如果大量用户反馈词库中缺少某些词汇或存在错误,应考虑加速更新。 - 技术进步 :随着自然语言处理技术的进步,可能需要定期对词库进行技术性更新,以适应新的算法和模型。

5.1.2 用户反馈与词库优化

用户反馈是词库更新的重要来源。收集和分析用户反馈能够帮助维护者及时发现问题,改进词库内容。以下是处理用户反馈的一些策略:

- 建立反馈机制 :提供便捷的反馈渠道,如在线表单、社区论坛或社交媒体平台。

- 分类处理 :根据反馈的类型进行分类,如新词添加、错误修正、词条丰富度提升等。

- 优先级评估 :评估每条反馈的紧急程度和重要性,合理安排更新优先级。

- 持续迭代 :根据反馈结果不断优化,形成持续改进的良性循环。

5.2 分词词库维护的最佳实践

5.2.1 长期维护的挑战与对策

分词词库长期维护过程中面临诸多挑战,如数据量庞大导致的维护困难、错误累积、新词不断产生等问题。应对这些挑战可以采取以下对策:

- 自动化工具 :开发自动化工具来处理常见的维护任务,比如自动监测和更新新词。

- 定期审查 :设置定期审查机制,对词库进行彻底检查和优化。

- 专家团队 :组建一个专家团队,负责复杂问题的分析和决策,确保更新的准确性和有效性。

5.2.2 保持词库高质量的保障措施

为确保词库长期保持高质量,需要采取以下保障措施:

- 质量评估体系 :建立一个全面的质量评估体系,定期检查词库的准确率、覆盖率、响应速度等关键指标。

- 更新和优化计划 :制定明确的更新和优化计划,确定优先级和责任分配。

- 技术培训与知识共享 :定期对维护团队进行技术培训,确保他们能够跟上行业最新趋势,并鼓励知识共享,以促进创新。

分词词库的持续更新与维护是保证中文分词技术有效性的关键,同时也是确保自然语言处理系统能适应语言演变和用户需求的前提。通过上述方法,可以有效应对维护分词词库过程中出现的各种挑战,保持其健康和活力。

简介:自然语言处理中,中文分词是文本分析等任务的基础。百度中文分词词库提供了大量经过挑选和标注的中文词汇,旨在提升分词算法的准确性和效率。该词库支持规则和统计两种分词方法,包含常规词汇和特殊规则,适用于新词识别和歧义消除。词库的不断更新适应了语言的动态变化。用户可通过特定网站下载词库文件,经处理后可应用于各类中文文本处理系统中。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)