阿里QwQ-32B:小模型大性能,本地部署的革命性突破

QwQ-32B的发布,标志着AI模型从“大力出奇迹”向“精巧出智慧”的转变。通过强化学习和小参数优化,QwQ-32B不仅实现了高性能,还大幅降低了部署成本。这一突破性进展,将为AI技术的普及和应用带来深远影响。1,3,5,6。

阿里QwQ-32B:小模型大性能,本地部署的革命性突破

2025年3月6日,阿里云正式发布了其最新的推理模型——QwQ-32B。这款仅有320亿参数的模型,凭借其卓越的性能和低资源消耗,迅速成为AI领域的热门话题。QwQ-32B不仅在数学推理、编程能力上与拥有6710亿参数的DeepSeek-R1媲美,还在多项基准测试中超越了多个知名大模型。更令人振奋的是,QwQ-32B支持在消费级显卡上本地部署,极大降低了使用门槛。

QwQ-32B的技术亮点

1. 小模型,大性能

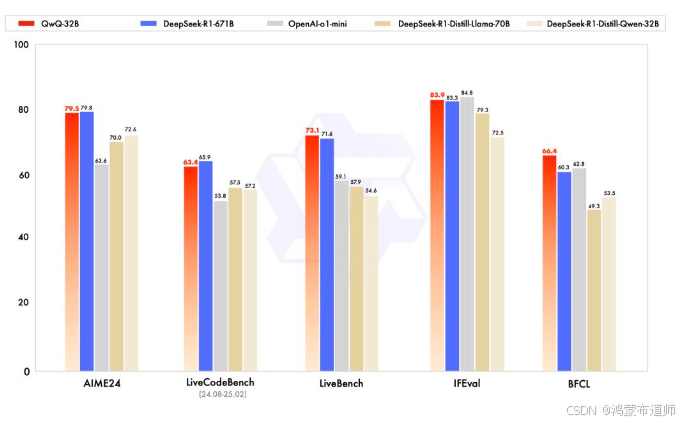

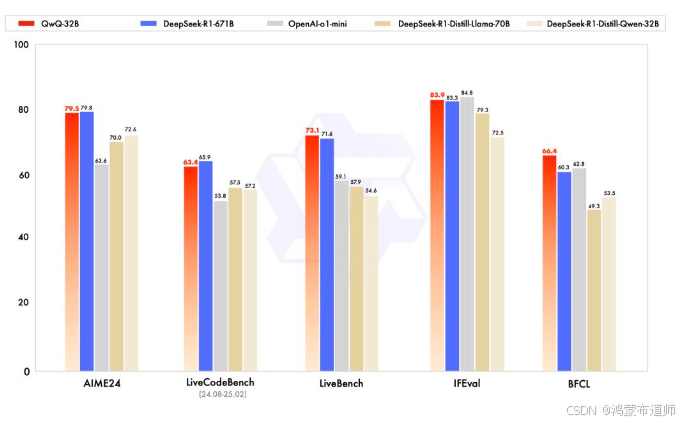

QwQ-32B的参数量仅为DeepSeek-R1的1/20,但在多项测试中表现优异。通过大规模强化学习(RL)技术,QwQ-32B在数学推理、编程任务以及通用能力上实现了质的飞跃。以下是QwQ-32B与DeepSeek-R1及其他模型的性能对比:

| 模型 | 参数量 | AIME24(数学推理) | LiveCodeBench(编程能力) | LiveBench(通用能力) |

|---|---|---|---|---|

| QwQ-32B | 32B | 92.5 | 89.3 | 88.7 |

| DeepSeek-R1 | 671B | 92.3 | 89.1 | 87.5 |

| o1-mini | 32B | 85.6 | 82.4 | 80.1 |

| DeepSeek-R1蒸馏版 | 32B | 86.7 | 83.2 | 81.3 |

2. 本地部署,低资源消耗

QwQ-32B的另一个显著优势是其低资源需求。运行QwQ-32B仅需24GB的显存,而DeepSeek-R1则需要超过1500GB的显存。这使得QwQ-32B能够在消费级显卡上轻松部署,极大降低了企业和开发者的使用成本。

3. 强化学习的“秘密武器”

QwQ-32B的成功离不开其两阶段强化学习策略。第一阶段专注于数学和编程任务,通过校验生成答案的正确性来提供反馈;第二阶段则针对通用能力进行训练,使用通用奖励模型和基于规则的验证器来提升指令遵循和人类对齐能力。这种分阶段的强化学习策略,使得QwQ-32B在保持高性能的同时,进一步优化了推理能力。

QwQ-32B的应用场景

QwQ-32B的推出,为多个行业带来了新的可能性。以下是其主要的应用场景:

- 自动化数据分析:QwQ-32B能够快速处理大量数据,提供结构化的分析结果,帮助企业做出更明智的决策。

- 软件开发:凭借其强大的编程能力,QwQ-32B可以辅助开发者编写代码,提升开发效率。

- 智能自动化:QwQ-32B能够执行复杂的任务,如自动化流程管理和智能客服,提升企业的运营效率。

开源与未来展望

QwQ-32B已在Hugging Face和ModelScope上开源,采用Apache 2.0许可证,允许企业和开发者免费使用和修改。阿里云团队表示,未来将继续探索强化学习在AI模型中的应用,进一步提升模型的智能和推理能力。

开源地址:

体验地址:

结语

QwQ-32B的发布,标志着AI模型从“大力出奇迹”向“精巧出智慧”的转变。通过强化学习和小参数优化,QwQ-32B不仅实现了高性能,还大幅降低了部署成本。这一突破性进展,将为AI技术的普及和应用带来深远影响。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)