GitHub 热榜|OpenManus:开源版 Manus 手把手教你本地快速部署指南

这款标榜 “全球首款通用型Agent” 的中国制造产品,凭借其创新定位迅速引发全网关注。官方演示视频中展现的AI自主行动能力,进一步放大了公众对通用智能的期待。由于邀请码获取难度较高,开源社区随即出现了 OpenManus、OWL、OpenHands 等多个替代方案。

一、引言

3月6日凌晨,Manus 正式发布。这款标榜 “全球首款通用型Agent” 的中国制造产品,凭借其创新定位迅速引发全网关注。官方演示视频中展现的AI自主行动能力,进一步放大了公众对通用智能的期待。由于邀请码获取难度较高,开源社区随即出现了 OpenManus、OWL、OpenHands 等多个替代方案。

Manus 非常棒,但 OpenManus 无需邀请码即可实现任何创意 🛫!

经过周末的部署调试,我在本地环境成功运行了 OpenManus,并对其功能进行了初步验证。本文将提供详细的配置指南,帮助开发者快速搭建测试环境,同时通过具体案例探讨当前通用Agent系统的实际能力边界。

初级入门定位让你跑起 OpenManus ,更多 OpenManus 请关注我,等后续内容

二、什么是 OpenManus?

开源社区新星 OpenManus 引爆AI研发领域!由MetaGPT社区顶尖贡献者与UIUC顶尖学者联袂打造,该项目首创基于强化学习(Reinforcement Learning)的大语言模型智能体优化范式,采用前沿的GRPO等算法实现LLM决策能力的突破性进化。

项目开源首周即登顶 GitHub 趋势榜,以现象级速度斩获 33,000+ 星标,引发全球开发者和AI研究者的疯狂追捧!这标志着学术界与开源社区的深度协同创新模式获得里程碑式成功。

三、环境搭建

提供 conda 和 uv 两种安装方式。推荐使用方式二(uv),因为它能提供更快的安装速度和更好的依赖管理。

方式一、 使用 conda

1. 创建新的 conda 环境:

1.1 下载 miniconda

windows 下载链接: 点击直接下载

MacOS / Linux 用户访问 --> 传送门 页面找到自己系统的安装包下载

1.2 安装miniconda

运行 conda , 点击开始菜单,找到 MiniConda Prompt 运行, 效果如下:

进入项目目录,比如我测试环境下载的目录是 C:\Users\vm\Documents\Downloads\OpenManus-main

cd C:\Users\vm\Documents\Downloads\OpenManus-main

回车 如图所示

1.3 创建环境

按照官方文档创建环境

conda create -n open-manus python=3.12

# 创建新的环境

# 默认有个名称叫 base 的环境,我们也可以直接使用,跳过这一步 #

# 如果创建了 open-manus 这个环境 需要激活,如下命令 , 如果就用 base 就不需要这一步了

conda activate open-manus

2. 下载代码:

2.1 官方仓库

网址: https://github.com/mannaandpoem/OpenManus

2.2 下载方案1

如果可以访问,并且可以使用 git 的,可以在终端(CMD) 中使用 git clone 下载

git clone https://github.com/mannaandpoem/OpenManus

2.3 下载方案2

访问官方仓库,点击页面上的 “Code” -> "Download Zip " 下载代码压缩包![[图片]](https://i-blog.csdnimg.cn/direct/19ad124ee45a4d139498c92730affaa4.png)

2.4 下载方案3

国内镜像下载 ZIP 代码

https://gh.llkk.cc/https://github.com/mannaandpoem/OpenManus/archive/refs/heads/main.zip

Git Clone

git clone https://gh.llkk.cc/https://github.com/mannaandpoem/OpenManus

如果你更新了最新的代码,要先安装依赖,确保最新的代码可以运行

# 设置 pip 国内镜像

pip config set global.index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

备注, 如果上面的清华源 一直安装不了依赖,可以尝试下面的腾讯源命令执行,再安装依赖

# pip config set global.index-url https://mirrors.cloud.tencent.com/pypi/simple

# 安装依赖

pip install -r requirements.txt

# 过程可能有点久,耐心等待

# 这个过程如果有红色错误,请重新执行命令重试

3. 安装依赖:

pip install -r requirements.txt

方式二、使用 uv(推荐)

1、安装 uv(一个快速的 Python 包管理器)

1.1 使用 curl

MacOS / Linux

curl -LsSf https://astral.sh/uv/install.sh | sh

Windows

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

如果遇到 无妨访问 github 的问题,可以使用 pip 安装的方式:

# With pip.

pip install uv

# Or pip3.

pip3 install uv

2、下载代码(同上使用conda)

在方式一,使用 conda 方式创建已经详细介绍了各种下载方式,这里就不再赘述了。

3、创建并激活虚拟环境

# 进入 OpenManus 目录

cd OpenManus

# 创建虚拟环境

uv venv

# 激活环境

source .venv/bin/activate # Unix/macOS 系统

# Windows 系统使用:

# .venv\Scripts\activate

4、 安装依赖:

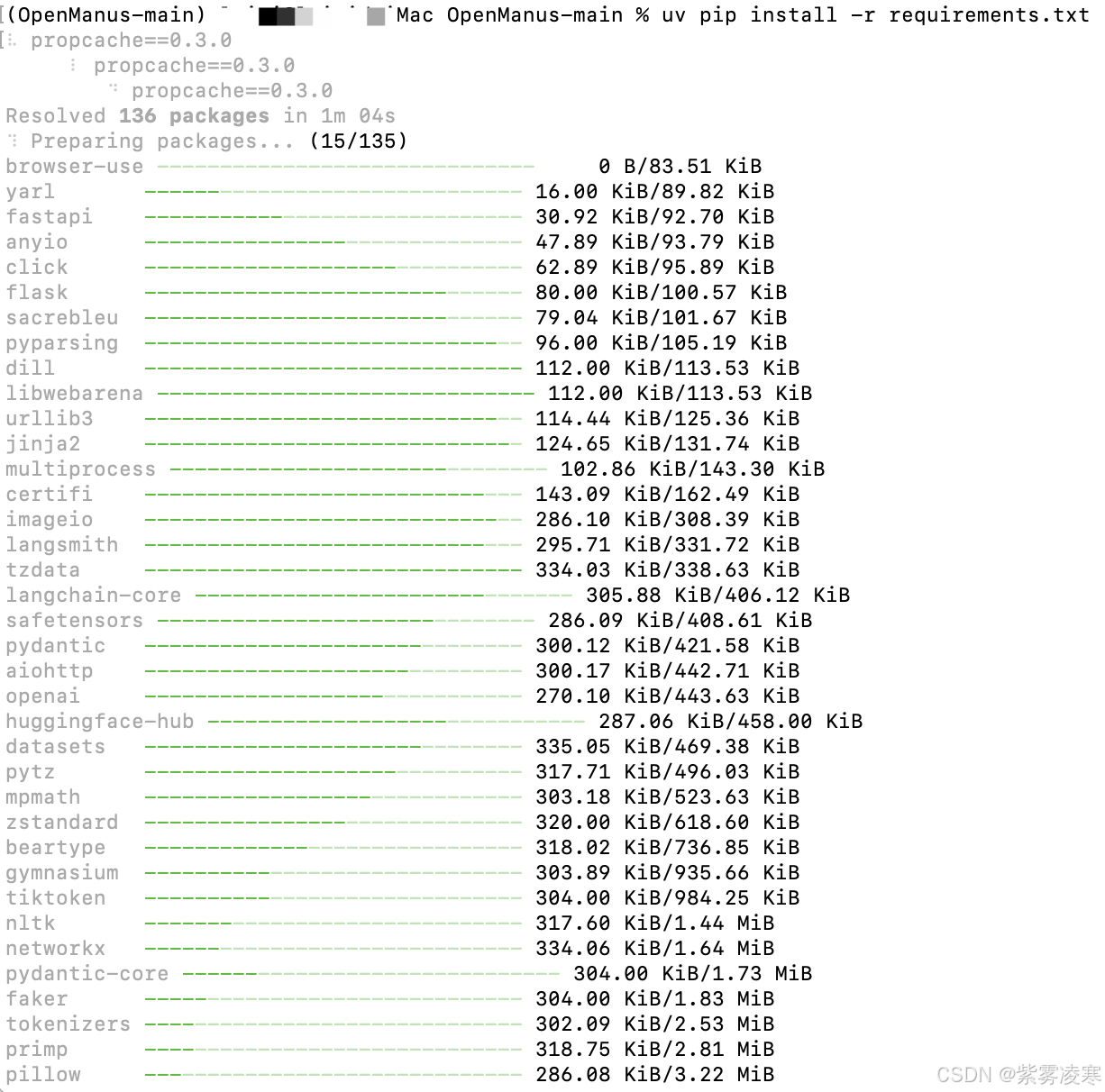

uv pip install -r requirements.txt

如果不出意外执行上述步骤我们会看到,如下图所示:

四、模型配置(要选择支持 tools 调用功能的模型!!!)

由于需要调用外部工具,所以需要大模型支持 tools (function calling ) 功能,这里会挑选几个供应商的模型配置给大家参考。

相同的模型,在不同的平台可能对 tools 的支持都不一样,有的支持有的不支持,所以还是要看选择的平台的那个具体的模型支持不支持

大多数 Key 只有在创建的时候让你复制一下,如果你忘记了重新创建一个即可!

1、DeepSeek 官方

目前只支持 deepseek-chat 模型 , 也就是 DeepSeek-V3 , DeekSeek-R1 由于不支持 tools 功能,目前暂不支持。

1.1 申请API Keys

访问 https://platform.deepseek.com/api_keys 创建一个 Api Key后复制保存下来,如果忘记了,重新创建一个即可.

1.2 配置(将 DeepSeek 后台保存的 key 替换 “sk-xxxx” 整体)

# Global LLM configuration

[llm]

model = "deepseek-chat"

base_url = "https://api.deepseek.com/v1"

api_key = "sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxx"

max_tokens = 8192

temperature = 0.0

# 备注: 目前多模态还没有整合,现在暂时可以不动

# Optional configuration for specific LLM models

[llm.vision]

model = "claude-3-5-sonnet"

base_url = "https://api.openai.com/v1"

api_key = "sk-..."

2、火山引擎

2.1 申请API Keys

访问 火山方舟大模型官网

DeepSeek满血版免费领啦!🙏 如果用我的邀请链接注册,我们最高双方可获得145元代金券,免费抵扣3625万tokens,畅享R1与V3模型!

参与入口:https://volcengine.com/L/A8N4byU1O5w/ 邀请码:QZOE56NS

进入后我们点击右上角的–>「API 接入」,切换出如下图所示的面板:

然后,我么你点击–>「创建 API key」就可以创建key,创建完成后我门可以进入第二步:

这里我们选择“DeepSeek-V3”,记住这类的 key 和 model 。

1.2 配置(将 DeepSeek 后台保存的 key 替换 “sk-xxxx” 整体)

# Global LLM configuration

[llm]

model = "deepseek-v3-241226"

base_url = "https://ark.cn-beijing.volces.com/api/v3"

api_key = "2ce5********************8cd7"

max_tokens = 8192

temperature = 0.0

# 备注: 目前多模态还没有整合,现在暂时可以不动

# Optional configuration for specific LLM models

[llm.vision]

model = "claude-3-5-sonnet"

base_url = "https://api.openai.com/v1"

api_key = "sk-..."

3、在OpenManus 中配置模型

OpenManus 需要配置使用的 LLM API Key,请按以下步骤设置:

- 在

config目录创建config.toml文件(可从示例复制):

# 使用命行方式复制

cp config/config.example.toml config/config.toml

# 也可以直接在 VSCode等代码编辑工具中打开 OpenManus,并复制

- 编辑

config/config.toml添加 API 密钥和自定义设置(这里我使用了火山引擎提供的 deepseek-v3):

# 全局 LLM 配置

[llm]

model = "deepseek-v3-241226"

base_url = "https://ark.cn-beijing.volces.com/api/v3"

api_key = "2ce5********************8cd7"

max_tokens = 8192

temperature = 0.0

# 可选特定 LLM 模型配置

[llm.vision]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为真实 API 密钥

五、快速启动

1、命令行

一行命令运行 OpenManus:

# 使用 python

python main.py

# 使用 python3

python3 main.py

然后通过终端输入你的意图!

如需 体验开发中版本 ,可运行:

# 使用 python

python run_flow.py

# 使用 python3

python3 run_flow.py

2、WebUI 版本

最新版本需要 front-end 分支才是带 Web UI,可以下载对应分支的源码

或者使用 git 切换分支

git fetch

git checkout front-end

# 安装依赖

pip install -r requirements.txt

# 运行 web ui

python app.py

# 运行完成后正常会自动打开浏览器,如果没有打开,请访问 http://localhost:5172/

六、运行测试(命令行)

python3 run_flow.py

正常我们会看到如下界面

我们测试一个问题:100以内的素数有哪些?

运行成功后我们看到它将结果输出在 primes_below_100.txt 文件中。

我们找到这个文件并打开,果然它将100以内的素数都输出在这里了~

七、遇到的问题(持续更新中。。。)

1、API error:404 page not found

模型 base_url 配置错误,请核对配置。 火山引擎的 base_url 为 https://ark.cn-beijing.volces.com/api/v3

2、API Error: Request timeout

基本上是 API 网站无法正常访问,需要梯子🪜FQ

3、This model’s maximum context length is 65536 tokens. However, you requested 69127 tokens (65031 in the messages, 4096 in the completion). Please reduce the length of the messages or completion.

超出模型最大 token ,需要更换支持更大上下文的模型

4、Model Not Exists

模型不存在,就是模型名称配置错误了,重新检查核对

5、Tool ‘google_search’ encountered a problem: 429 Client Error: Too Many Requests for url:

Google 搜索模块 频率过高,目前没有很好的解决方法

6、The tool call is not supported

没有选对支持 tools 的模型, 需要更换模型

7、卡在 30/30 轮

目前程序设置了 最大 30 轮的配置,以后会迭代优化成自动配置

延伸阅读

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)