基于Spark商品销售数据可视化分析系统 Hadoop和Hive 机器学习预测算法 讲解视频 论文 大数据毕业设计 销量预测✅

基于Spark商品销售数据可视化分析系统 Hadoop和Hive 机器学习预测算法 讲解视频 论文 大数据毕业设计 销量预测✅

博主介绍:✌全网粉丝10W+,前互联网大厂软件研发、集结硕博英豪成立工作室。专注于计算机相关专业项目实战6年之久,选择我们就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅🍅感兴趣的可以先收藏起来,点赞、关注不迷路,大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助同学们顺利毕业 。🍅

1、毕业设计:2025年计算机专业毕业设计选题汇总(建议收藏)✅

1、项目介绍

Spark商品销售数据可视化分析+机器学习预测算法+讲解视频+论文

技术栈:

大数据技术、Spark、Hadoop、Hive、python语言、Django后端框架、vue前端框架、

selenium爬虫技术、淘宝数据、Echarts可视化、DataV、机器学习线性回归预测模型、销量预测

2、项目界面

(1)商品销售数据分析大屏

(2)机器学习线性回归预测模型销量预测

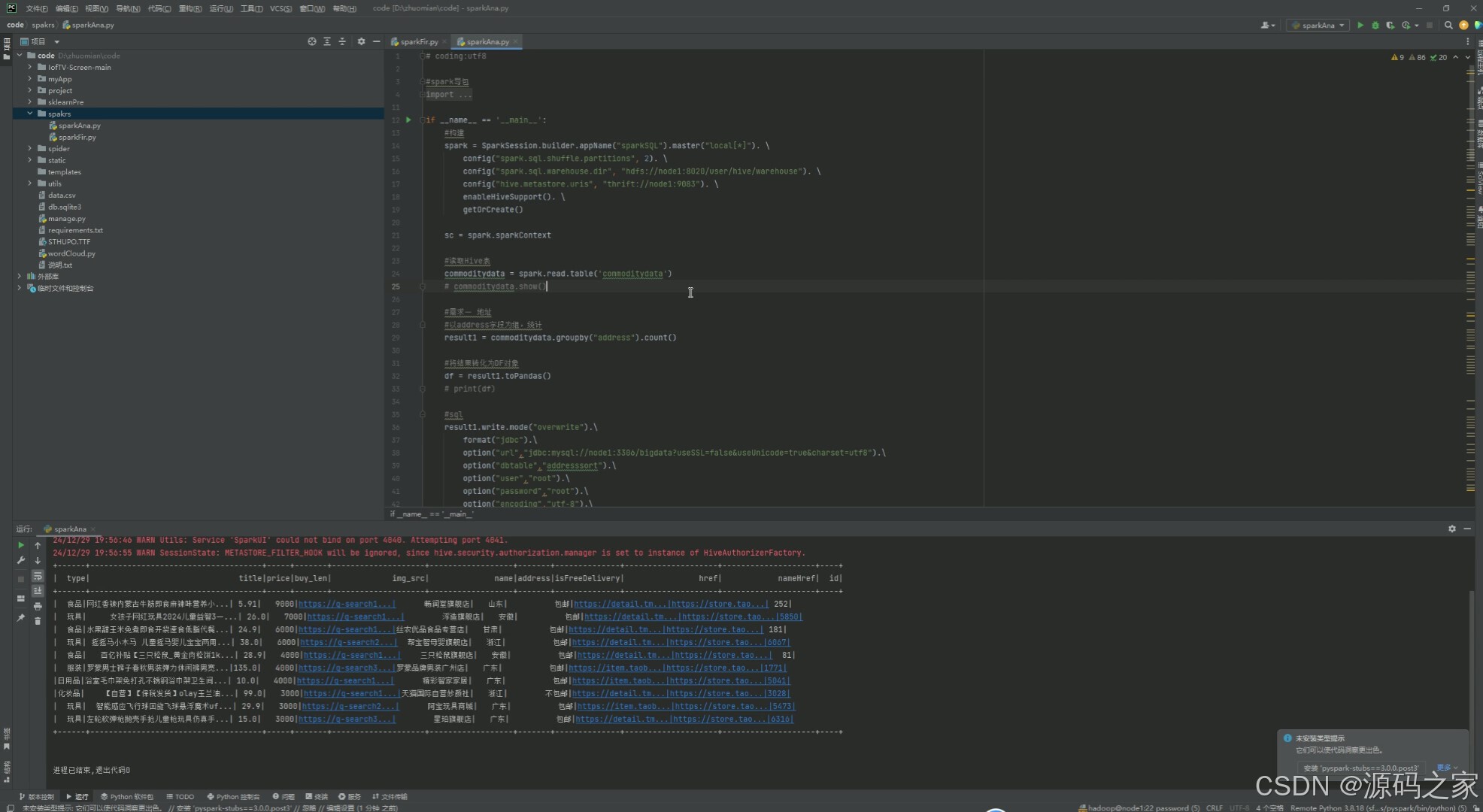

(3)spark大数据分析

3、项目说明

随着大数据技术的迅猛发展,许多行业亟需提升商品销售预测的准确性与效率。传统的商品销售分析多依赖人工统计与经验判断,存在数据处理速度慢、预测精度低的问题。现有系统难以快速从大量商品数据中提取有效信息,且缺乏智能化预测能力,难以适应快速变化的市场需求。

本系统旨在通过大数据技术实现商品销售数据的智能化采集、分析与预测。前端使用Vue框架进行数据展示与交互,后端采用Django框架进行业务处理与数据管理。数据存储采用Hive数据库,支持大规模数据的高效存储与查询。系统功能包括商品数据采集、商品数据分析与销售预测,利用Selenium爬虫技术从淘宝获取实时商品数据,通过Spark与Hadoop进行数据处理与分析,结合机器学习中的线性回归模型进行销售预测,并通过Echarts与DataV实现数据可视化。

关键词:商品数据分析,Python,销售预测,Django

本文基于现代化大数据分析与机器学习技术,设计并实现了一个商品销售分析预测系统。论文先从研究背景与目的入手,分析国内外在商品销售分析领域的研究现状,为本系统开发提供理论依据。在技术选型上,论文详细介绍了Python语言、Django框架、ECharts、Vue框架以及线性回归模型的特点与应用方式。然后通过需求分析明确系统的功能与非功能需求,并从技术、操作、社会与经济多个角度进行可行性分析,为系统开发的合理性提供充分论证。在系统设计与实现部分,论文对系统的总体架构、功能模块以及实现步骤进行详细说明,涵盖了数据爬取、清洗、存储、分析与可视化等全流程技术实现。商品销售数据采集模块实现了从电商平台获取数据并存储至数据库,商品销售数据分析模块通过多维度数据分析提供了直观的数据洞察,商品销售数据预测模块利用线性回归模型对未来销量进行科学预测,为用户提供决策支持。

论文的后续部分通过详细测试验证了系统的功能和性能稳定性,保证系统满足需求设计与预期目标。测试用例覆盖了用户模块、数据采集模块、数据分析模块和数据预测模块,测试结果表明系统在功能、准确性和交互性方面表现优异。论文的最后总结了研究工作的主要成果,指出系统在电商领域的应用价值,并对未来可能的优化方向提出建议。本研究完成了从理论到实践的完整技术实现,对商品销售的智能化管理与数据驱动决策提供了技术支持,也为相关领域的研究和开发提供了参考价值。

4、核心代码

# coding:utf8

#spark导包

from pyspark.sql import SparkSession

from pyspark.sql import functions as F

from pyspark.sql.functions import count

from pyspark.sql.functions import monotonically_increasing_id

from pyspark.sql.types import StructType,StructField,IntegerType,StringType,FloatType

from pyspark.sql.functions import col,sum,when

from pyspark.sql.functions import desc,asc

if __name__ == '__main__':

#构建

spark = SparkSession.builder.appName("sparkSQL").master("local[*]"). \

config("spark.sql.shuffle.partitions", 2). \

config("spark.sql.warehouse.dir", "hdfs://node1:8020/user/hive/warehouse"). \

config("hive.metastore.uris", "thrift://node1:9083"). \

enableHiveSupport(). \

getOrCreate()

sc = spark.sparkContext

#读取Hive表

commoditydata = spark.read.table('commoditydata')

# commoditydata.show()

#需求一 地址

#以address字段为组,统计

result1 = commoditydata.groupby("address").count()

#将结果转化为DF对象

df = result1.toPandas()

# print(df)

#sql

result1.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","addresssort").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#写入HIVE

result1.write.mode("overwrite").saveAsTable("addresssort","parquet")

# spark.sql("select * from addresssort").show()

#需求二:各类型销量占比

#以type为组

result2 = commoditydata.groupBy("type").sum("buy_len").withColumnRenamed("sum(buy_len)","total_bue_len")

#

df = result2.toPandas()

# print(df)

#sql

result2.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","typesort").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#HIVE

result2.write.mode("overwrite").saveAsTable("typesort","parquet")

# spark.sql("select * from typesort").show()

#需求三:统计每个省市日销100+的店铺 TOP10

#province

#按“address",”name“为组

result3 = commoditydata.groupBy("address","name").\

agg({"buy_len":"sum"}).withColumnRenamed("sum(buy_len)","total_buy_len").\

filter("total_buy_len > 100").\

drop_duplicates(subset=["name"]).\

groupby("address").count()

result3 = result3.orderBy(col("count").desc()).limit(10)

df = result3.toPandas()

# print(df)

#sql

result3.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","provincesort").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#HIVE

result3.write.mode("overwrite").saveAsTable("provincesort","parquet")

# spark.sql("select * from provincesort").show()

#需求四:统计每种类型buy_len的总和以及buy_len与price的总和

result4 = commoditydata.groupBy("type").agg(

F.sum("buy_len").alias("total_buy_len"),

F.sum(F.col("buy_len") * F.col("price")).alias("sum_buy_len_price")

)

result4 = result4.withColumn("ration",F.col("sum_buy_len_price")/F.col("total_buy_len"))

df = result4.toPandas()

# print(df)

#sql

result4.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","salerate").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#HIVE

result4.write.mode("overwrite").saveAsTable("salerate","parquet")

# spark.sql("select * from salerate").show()

#需求五:店铺/商品销售额统计

resultDouble = commoditydata.withColumn("volume",when(col("buy_len") * col("price") < 100,"小于100")

.when(col("buy_len") * col("price") < 200,"小于200")

.when(col("buy_len") * col("price") < 500,"小于500")

.when(col("buy_len") * col("price") < 1000,"小于1000")

.when(col("buy_len") * col("price") < 5000,"小于5000")

.when(col("buy_len") * col("price") < 10000,"小于10000")

.otherwise("大于10000"))

result5 = resultDouble.drop_duplicates(["title"])

result5 = result5.groupby("volume").agg(count("title").alias("title_count"))

result6 = resultDouble.drop_duplicates(["name"])

result6 = result6.groupby("volume").agg(count("name").alias("name_count"))

# result5.show()

# result6.show()

result_cobine = result5.join(result6,"volume")

# result_cobine.show()

#sql

result_cobine.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","storeproduct").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#HIVE

result_cobine.write.mode("overwrite").saveAsTable("storeproduct","parquet")

# spark.sql("select * from storeproduct").show()

#需求6:商品销量top10

#productTop

resultList = commoditydata.orderBy("buy_len",ascending=False).limit(10)

# resultList.show()

#sql

resultList.write.mode("overwrite").\

format("jdbc").\

option("url","jdbc:mysql://node1:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8").\

option("dbtable","productTop10").\

option("user","root").\

option("password","root").\

option("encoding","utf-8").\

save()

#HIVE

resultList.write.mode("overwrite").saveAsTable("productTop10","parquet")

spark.sql("select * from productTop10").show()

5、项目获取

biyesheji0005 或 bysjbysj (绿色聊天软件)

🍅由于篇幅限制,获取完整文章或源码、代做项目的,查看我的【用户名】、【专栏名称】、【顶部选题链接】就可以找到我啦🍅

感兴趣的可以先收藏起来,点赞、关注不迷路,下方查看👇🏻获取联系方式👇🏻

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)