部署llava时出现的错误:ERROR: Could not build wheels for flash-attn, which is required to install pyproject.t

最近作者正在尝试部署多模态大语言模型llava,本文记录一下部署时遇到的问题。

·

背景:

最近作者正在尝试部署多模态大语言模型llava,本文记录一下部署时遇到的问题

运行环境:

平台:AutoDL

GPU型号:RTX4090

Pytorch版本:python3.8+torch2.0.1+CUDA11.8

问题:

我跟着README.md文件一步步的执行到以下命令时出现错误:

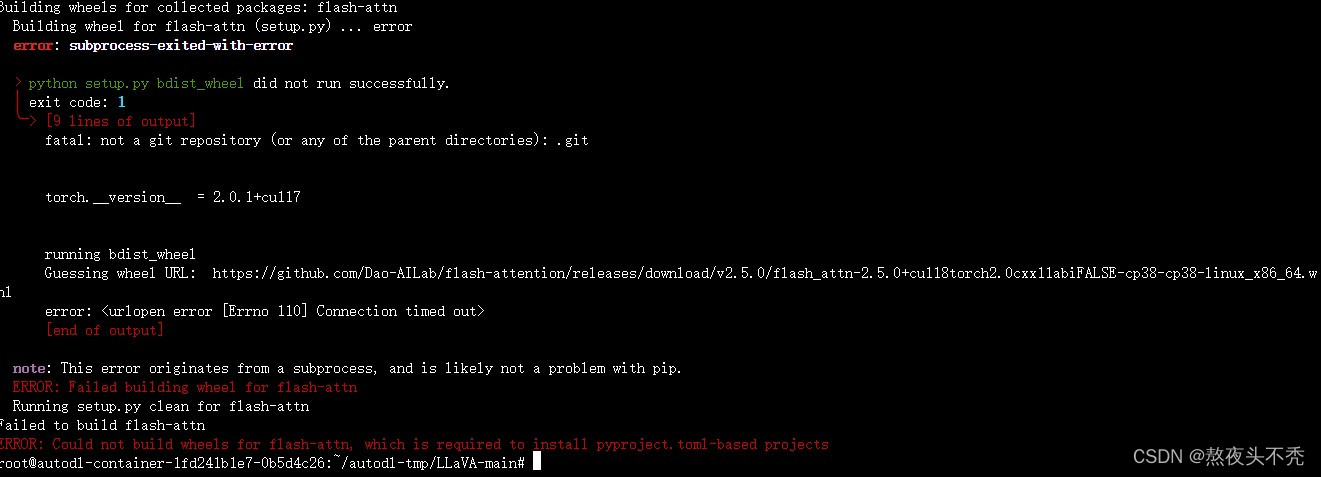

pip install flash-attn --no-build-isolation错误如下图所示:

我在CSDN上看到有位博主给出了一种解决方法,就是关闭梯子再次尝试,原文链接:链接,但是这个方法对我不起作用。

我在CSDN上看到有位博主给出了一种解决方法,就是关闭梯子再次尝试,原文链接:链接,但是这个方法对我不起作用。

解决方法:

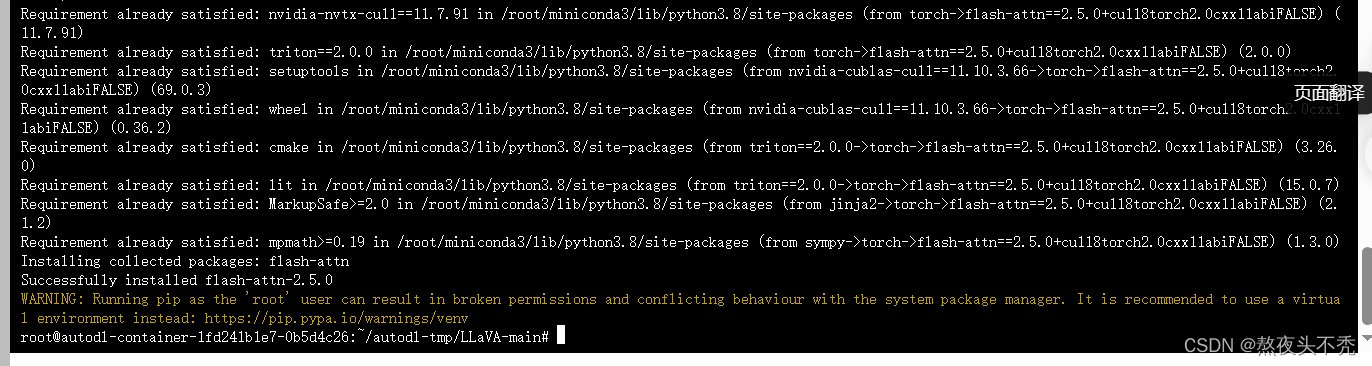

其实解决方法已经在报错中给出,报错中给出了下载flash-attn的URL地址,点击该地址会跳转到另一个页面自动下载文件flash_attn-2.5.0+cu118torch2.0cxx11abiFALSE-cp38-cp38-linux_x86_64.whl,将下载好的文件上传到项目文件下,运行以下命令直接下载:

pip install flash_attn-2.5.0+cu118torch2.0cxx11abiFALSE-cp38-cp38-linux_x86_64.whl即可下载成功

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)